Merci beaucoup de ton retour, je ne connais pas du tout ce pan de home assistant

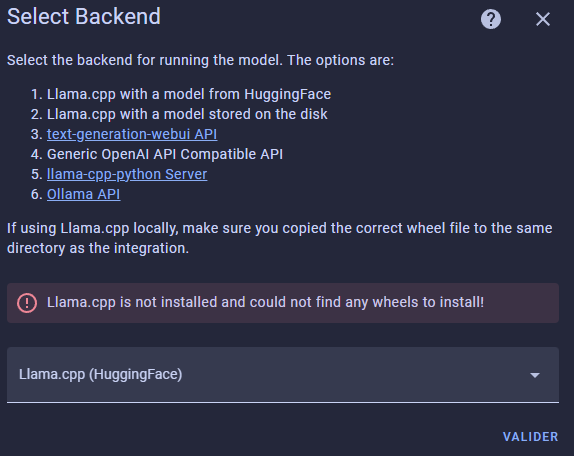

J’ai donc tenté de rajouter llama-cpp-python dans le manifest de l’extension concernée, redémarré HA, et essayer de lancer l’intégration, mais là je me fais insulter sauvagement par les logs, et ça dépasse clairement mes compétences

Méchants logs pas beaux

`× Encountered error while generating package metadata.

╰─> See above for output.

note: This is an issue with the package mentioned above, not pip.

hint: See above for details.

2024-02-14 16:37:12.621 ERROR (SyncWorker_3) [homeassistant.util.package] Unable to install package llama-cpp-python: error: subprocess-exited-with-error

× Preparing metadata (pyproject.toml) did not run successfully.

│ exit code: 1

╰─> [40 lines of output]

Traceback (most recent call last):

File « /usr/local/lib/python3.12/site-packages/pip/_vendor/pyproject_hooks/_in_process/_in_process.py », line 353, in

main()

File « /usr/local/lib/python3.12/site-packages/pip/_vendor/pyproject_hooks/_in_process/_in_process.py », line 335, in main

json_out[‹ return_val ›] = hook(**hook_input[‹ kwargs ›])

^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/local/lib/python3.12/site-packages/pip/_vendor/pyproject_hooks/_in_process/_in_process.py », line 149, in prepare_metadata_for_build_wheel

return hook(metadata_directory, config_settings)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /tmp/pip-build-env-q0iqqkak/overlay/lib/python3.12/site-packages/scikit_build_core/build/init.py », line 72, in prepare_metadata_for_build_wheel

return _build_wheel_impl(

^^^^^^^^^^^^^^^^^^

File « /tmp/pip-build-env-q0iqqkak/overlay/lib/python3.12/site-packages/scikit_build_core/build/wheel.py », line 151, in _build_wheel_impl

cmake = CMake.default_search(version=settings.cmake.version, env=os.environ)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /tmp/pip-build-env-q0iqqkak/overlay/lib/python3.12/site-packages/scikit_build_core/cmake.py », line 59, in default_search

cmake_program = best_program(candidates, version=version)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /tmp/pip-build-env-q0iqqkak/overlay/lib/python3.12/site-packages/scikit_build_core/program_search.py », line 145, in best_program

for program in programs:

File « /tmp/pip-build-env-q0iqqkak/overlay/lib/python3.12/site-packages/scikit_build_core/program_search.py », line 101, in get_cmake_programs

yield get_cmake_program(cmake_path)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /tmp/pip-build-env-q0iqqkak/overlay/lib/python3.12/site-packages/scikit_build_core/program_search.py », line 80, in get_cmake_program

result = Run().capture(cmake_path, « –version »)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /tmp/pip-build-env-q0iqqkak/overlay/lib/python3.12/site-packages/scikit_build_core/_shutil.py », line 43, in capture

return self._run(args, capture=True)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /tmp/pip-build-env-q0iqqkak/overlay/lib/python3.12/site-packages/scikit_build_core/_shutil.py », line 71, in _run

return subprocess.run(

^^^^^^^^^^^^^^^

File « /usr/local/lib/python3.12/subprocess.py », line 548, in run

with Popen(*popenargs, **kwargs) as process:

^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/local/lib/python3.12/subprocess.py », line 1026, in init

self._execute_child(args, executable, preexec_fn, close_fds,

File « /usr/local/lib/python3.12/subprocess.py », line 1950, in _execute_child

raise child_exception_type(errno_num, err_msg, err_filename)

PermissionError: [Errno 13] Permission denied: ‹ /tmp/pip-build-env-q0iqqkak/normal/lib/python3.12/site-packages/cmake/data/bin/cmake ›

[end of output]

note: This error originates from a subprocess, and is likely not a problem with pip.

error: metadata-generation-failed

× Encountered error while generating package metadata.

╰─> See above for output.

note: This is an issue with the package mentioned above, not pip.

hint: See above for details.

2024-02-14 16:37:12.622 ERROR (MainThread) [aiohttp.server] Error handling request

Traceback (most recent call last):

File « /usr/local/lib/python3.12/site-packages/aiohttp/web_protocol.py », line 452, in _handle_request

resp = await request_handler(request)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/local/lib/python3.12/site-packages/aiohttp/web_app.py », line 543, in _handle

resp = await handler(request)

^^^^^^^^^^^^^^^^^^^^^^

File « /usr/local/lib/python3.12/site-packages/aiohttp/web_middlewares.py », line 114, in impl

return await handler(request)

^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/components/http/security_filter.py », line 91, in security_filter_middleware

return await handler(request)

^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/components/http/forwarded.py », line 100, in forwarded_middleware

return await handler(request)

^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/components/http/request_context.py », line 28, in request_context_middleware

return await handler(request)

^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/components/http/ban.py », line 80, in ban_middleware

return await handler(request)

^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/components/http/auth.py », line 235, in auth_middleware

return await handler(request)

^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/components/http/headers.py », line 31, in headers_middleware

response = await handler(request)

^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/components/http/view.py », line 149, in handle

result = await handler(request, **request.match_info)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/components/http/decorators.py », line 72, in with_admin

return await func(self, request, *args, **kwargs)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/components/config/config_entries.py », line 153, in post

return await super().post(request)

^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/components/http/data_validator.py », line 72, in wrapper

result = await method(view, request, data, *args, **kwargs)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/helpers/data_entry_flow.py », line 71, in post

result = await self._flow_mgr.async_init(

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/config_entries.py », line 947, in async_init

flow, result = await task

^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/config_entries.py », line 965, in _async_init

flow = await self.async_create_flow(handler, context=context, data=data)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/config_entries.py », line 1076, in async_create_flow

handler = await _async_get_flow_handler(

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/config_entries.py », line 2294, in _async_get_flow_handler

await _load_integration(hass, domain, hass_config)

File « /usr/src/homeassistant/homeassistant/config_entries.py », line 2270, in _load_integration

await async_process_deps_reqs(hass, hass_config, integration)

File « /usr/src/homeassistant/homeassistant/setup.py », line 467, in async_process_deps_reqs

await requirements.async_get_integration_with_requirements(

File « /usr/src/homeassistant/homeassistant/requirements.py », line 52, in async_get_integration_with_requirements

return await manager.async_get_integration_with_requirements(domain)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File « /usr/src/homeassistant/homeassistant/requirements.py », line 175, in async_get_integration_with_requirements

await self._async_process_integration(integration, done)

File « /usr/src/homeassistant/homeassistant/requirements.py », line 190, in _async_process_integration

await self.async_process_requirements(

File « /usr/src/homeassistant/homeassistant/requirements.py », line 255, in async_process_requirements

await self._async_process_requirements(name, missing)

File « /usr/src/homeassistant/homeassistant/requirements.py », line 293, in _async_process_requirements

raise RequirementsNotFound(name, list(failures))

homeassistant.requirements.RequirementsNotFound: Requirements for llama_conversation not found: [‹ llama-cpp-python ›].`

Je vais rollback du coup, et essayer d’explorer plus loin le GIT initial, des fois que j’aie manqué un truc…

![]()