Disons qu’un accès aux volumes docker depuis l’hôte ça permet un autre regard, c’est pas la solution miracle mais ça permet de pointer l’endroit et de remonter un peu la pile

Oui, il y a de l’optimisation à faire dans ce que je conserve, c’est certain…

Garder 12 mois a du sens pour moi pour faire des comparatifs sur des périodes comparables (en termes de température, de conso, de rendement solaire… bref, c’est tout l’objet d’une BDD en fait !).

Je ne sais pas si ça existe mais mon idéal serait d’avoir des données à la minute pour l’analyse immédiate puis qu’ensuite un script vienne supprimer les données détaillées pour ne garder qu’un détail à l’heure par exemple (pour diminuer le nb d’enregistrement en base). ça vous parle ?

Pour vous tenir informés, j’ai arrêté tous les les add-ons sauf Node-Red et MariaDB : la croissance du volume s’est poursuivi.

J’ai ensuite arrêté Node Red et MariaDB + coupé la redirection de port wan to lan (au cas où si DDOS…) : le volume est redescendu et a arrêté de croitre.

Je vais commencer à réactiver les modules un par un.

Si c’est le module MariaDB, si je le supprime et que je le remets, quel impact ? perte de tout l’historique « seulement » ?

Merci pour votre aide

Wow ne fais pas ça! Tu perdrait tout, aussi bien les valeurs des entitiés, les statistiques et les statistiques long terme…!

C’est un vaste sujet qui est abordé régulièrement.

De base l’idée de la DB / Recorder, c’est de garder quelques jours pour les besoins purement domotique… c’est pour ça que c’est plus optimisé pour garder 7 ou 10 jours.

Mais en plus par défaut HA garde aussi un historique plus long terme (sans limite je crois) qui sont les « statistiques » long terme, c’est principalement tout ce qui est dans le dashboard énergie.

Là tu peux revenir à l’heure près, les données sont stockées dans un format agrégé.

Pour garder des données long terme perso, certains utilisent InfluxDB ou une autre base externe.

Chez moi par exemple, je garde un enregistrement par jour pour historique et faire le type de comparaisons dont tu parles. J’en suis à 10 ans d’électricité, températures, chauffage, et plus récent, voiture et solaire. Mais je fais ça en dehors de HA car je veux gérer mon format de données.

ok noté, mais le soucis c’est que purger ma base, c’est plus que galère vu le volume de données.

J’ai passé une requête de DELETE tout à l’heure, ça a tourné tout un moment sans qu’il ne supprime aucun enregistrement. Donc je suis preneur des bonnes idées…

Je pensais que la bases ne contenait que des infos de valeurs des entités.

Si je supprime la BDD, si je perds l’historique, tant pis mais là, il faut que ça fonctionne. ça fait une semaine que ça dure et toutes mes automatisations me manquent cruellement ![]() !

!

ça m’intéresse, comment tu fais ?

Il faut déjà confirmer que c’est ça qui grossit aussi vite, car je comprends bien qu’elle soit énorme car du garde 6mois, mais dans une journée, ça ne devrait pas être énorme non plus ce qui est ajouté, clairmeent pas 10go toutes les 8 heures…

Les données « court » terme, celles des sensors c’est dans les tables « states » et « event » comme tu peux le voir.

IN.COM.PRE.HEN.SIBLE !

19h09 : 106.5 Go

19h48 : 110.7

19h53 : 111.6

arrêt de tous adds on

20h58 : 102.8

remise en marche de quelques adds on

22h00 : 104.0

22h05 : 104.3

22h09 : 104.9

arrêt de tous adds on

22h10 : 105.1

22h12 : 105.4

22h15 : 105.7

22h18 : 106.1

22h27 : 107

… et ça gonfle encore alors que tout est off…

C’est quoi ton hardware derrière tout ça. Ça ne serait pas du swap qui engendre la fluctuation.

Ps: je viens de faire le lien avec ta chaîne youtube. C’est en partie grâce (où à cause) à toi que j’ai lâché jeedom

Derrière tout c’est un PC en windows sur lequel j’ai virtualisé Home Assistant avec du VMWare.

Et sur le PC en lui-même, c’est un SSD, 16 Go de RAM et un i3 me semble-t-il.

Oui, effectivement, j’ai fait qq vidéos, j’espère que tu ne regrettes pas ton choix ![]() !

!

OK donc avec 2 voire 4go pour la vm ?

Fait un tour dans l’hyperviseur pour voir l’utilisation des ressources

Concert ma bascule, j’ai pas trop de regrets ![]()

Hello,

Pour info, j’ai truncate les tables states, events et state_attributes qui étaient volumineuses (en nb de records et en poids). Tout semble être rentré dans l’ordre avec moins de données à gérer.

J’ai mis des sondes sur la croissance du disque pour surveiller…

Merci pour vos bonnes idées.

pour trouver les fichiers qui fond plus de 900mega tu peux, dans une console, taper :

find / -type f -size +900M

pour vider un syslog (si c’est bien un log qui est enorme) :

sudo echo "" > /var/log/syslog

Salut,

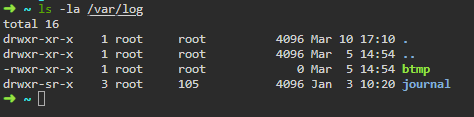

En fait sur l’hôte de HAOS il n’y a pas de syslog:

Ha oui en y repensant c’est directement sous proxmox que j’avais mon pb de fichier énorme et qui grossissaient a vu d’œil a cause de ma clé USB.

Mais.la première commande que je donne permet de trouver les gros fichiers s’il y en a…