Bonjour à tous ![]()

Voilà bientôt 1 semaine que je teste la clé Zlinky de Lixee et c’est plutôt sympathique !

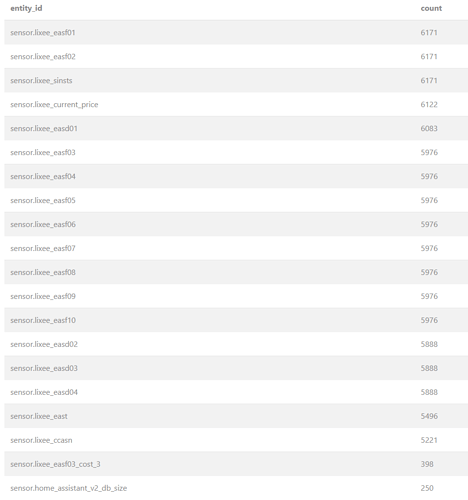

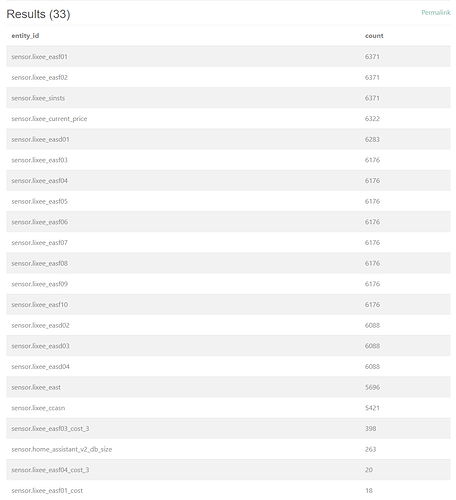

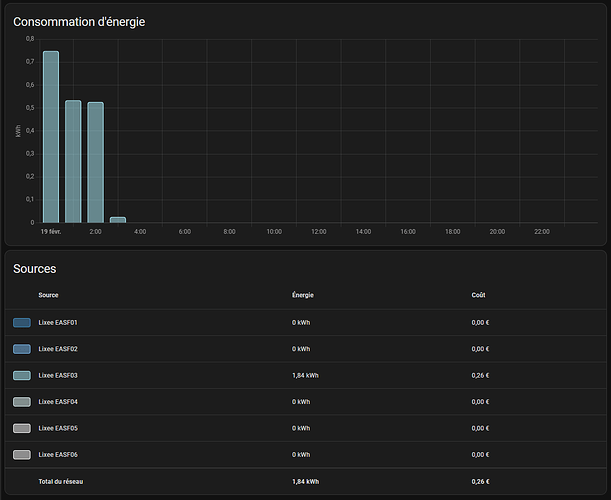

Mais depuis que je suis passé en TIC Standard (il me semble que c’est depuis ce moment) je me suis rendu compte que la clé spammait littéralement mes logs avec un flux (très) massif d’info, ma BDD est montée à 5 Go (!!), j’ai tout reset pour repartir de 0 avec configuration du recorder etc. Opération faite ce matin, ma BDD est passée de 0 à 100 mégas ce soir. ![]()

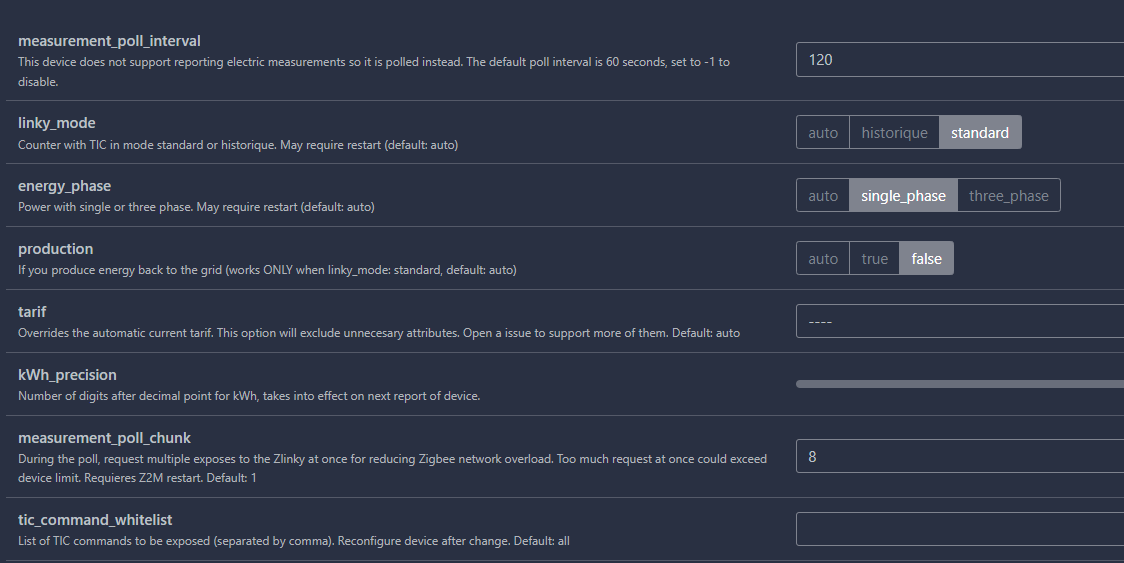

Mon problème : malgré moult tests sur la configuration du Zlinky (dans les paramètres du Zlinky : poll interval, measurement poll chunk) dans le panneau de Zigbee2MQTT, rien n’y fait je suis toujours spammé de manière aléatoire par les requêtes mqtt et j’ai même pas l’impression que ces paramètres changent beaucoup de choses…

Actuellement voici ma configuration :

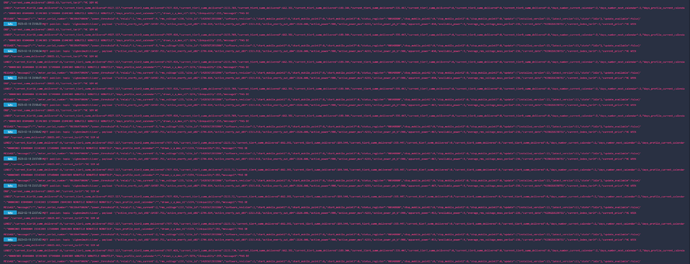

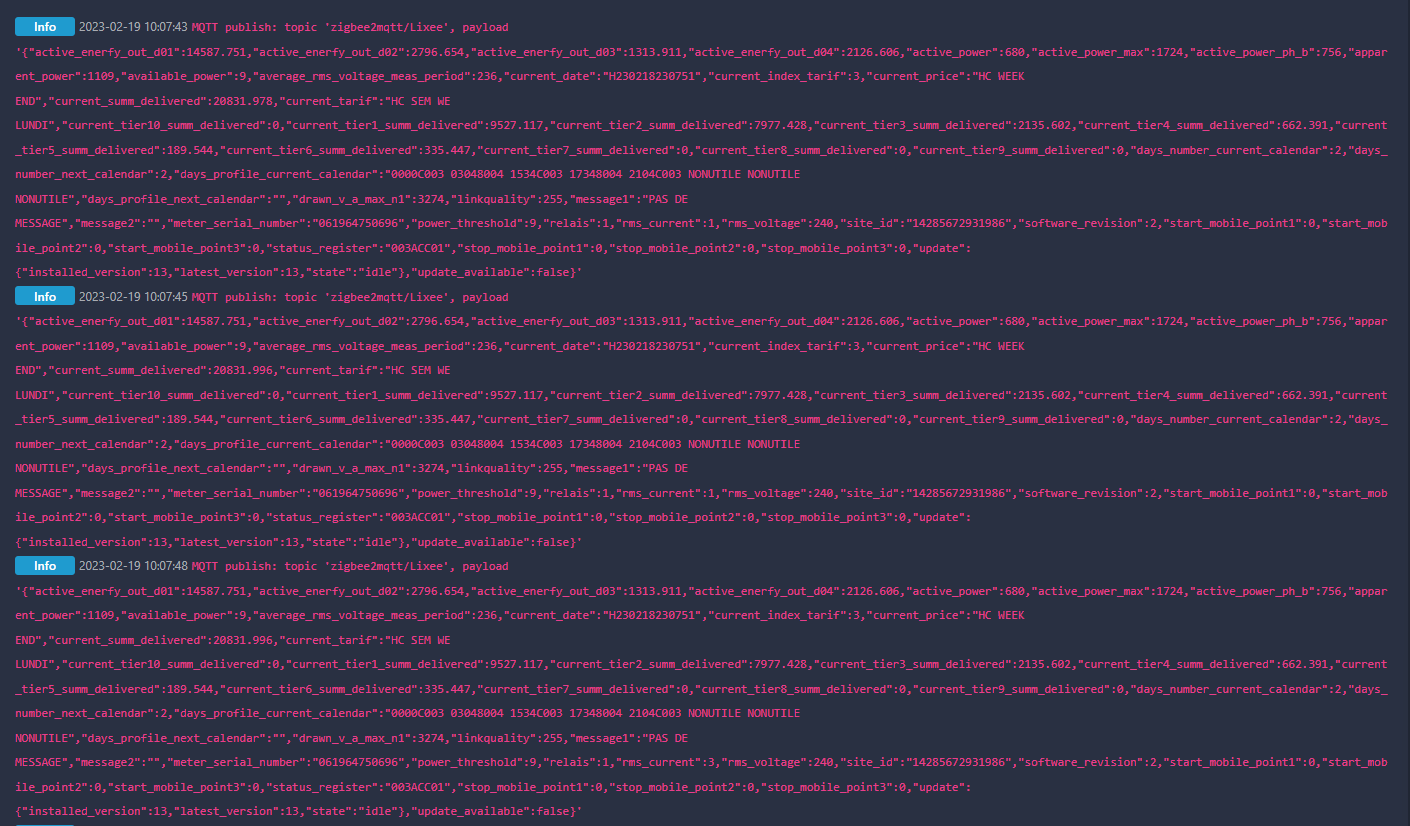

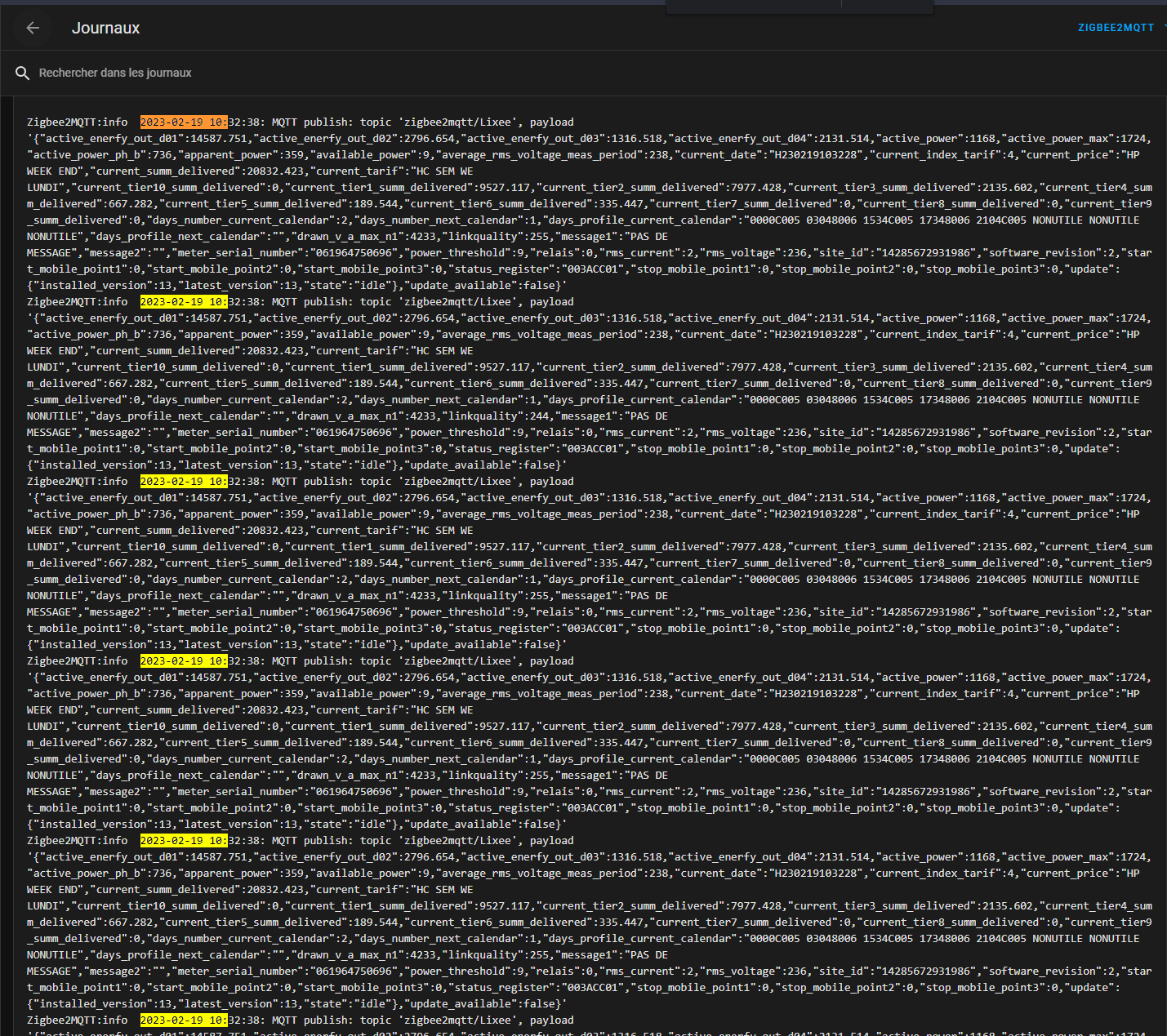

Mais malgré le poll à 120 sec (testé à 0, 60, 90, 30, 50 etc), on peut voir dans les logs que j’ai des retours de manière totalement chaotiques et aléatoires.

Parfois c’est environ toutes les 30 sec (malgré les 60 ou 120 sec demandées dans le poll interval) avec des retours en double ou triple. Parfois, je peux même monter à 45 retours sur la même seconde, mon record. Forcément la BDD n’aime pas et gonfle à vue d’oeil.

Je ne trouve rien sur le net concernant ce spam incessant du Zlinky et de sa configuration qui ne semble pas être prise en compte… J’avais vu ici quelqu’un mettre le measurement_poll_chunk à 8 mais là aussi, que je mette 0, 1, 800 etc rien ne semble changer, ou très très peu.

Note : à chaque modification, je « reconfigure » le Zlinky dans l’interface Z2M, je relance le module, je relance même parfois tout HA, rien n’y fait.

Quelqu’un sait comment gérer ce spam ou a déjà eu ce problème ?

Un grand merci par avance pour ceux qui pourront prendre un peu de leur temps pour m’aider ![]()

Ma configuration

System Information

| version | core-2023.2.5 |

|---|---|

| installation_type | Home Assistant OS |

| dev | false |

| hassio | true |

| docker | true |

| user | root |

| virtualenv | false |

| python_version | 3.10.7 |

| os_name | Linux |

| os_version | 5.15.84-v8 |

| arch | aarch64 |

| timezone | Europe/Paris |

| config_dir | /config |

Home Assistant Community Store

| GitHub API | ok |

|---|---|

| GitHub Content | ok |

| GitHub Web | ok |

| GitHub API Calls Remaining | 4979 |

| Installed Version | 1.29.0 |

| Stage | running |

| Available Repositories | 1205 |

| Downloaded Repositories | 3 |

Home Assistant Cloud

| logged_in | true |

|---|---|

| subscription_expiration | 1 janvier 2018 à 01:00 |

| relayer_connected | false |

| remote_enabled | true |

| remote_connected | false |

| alexa_enabled | false |

| google_enabled | true |

| remote_server | null |

| can_reach_cert_server | ok |

| can_reach_cloud_auth | ok |

| can_reach_cloud | ok |

Home Assistant Supervisor

| host_os | Home Assistant OS 9.5 |

|---|---|

| update_channel | stable |

| supervisor_version | supervisor-2023.01.1 |

| agent_version | 1.4.1 |

| docker_version | 20.10.22 |

| disk_total | 28.5 GB |

| disk_used | 4.9 GB |

| healthy | true |

| supported | true |

| board | rpi4-64 |

| supervisor_api | ok |

| version_api | ok |

| installed_addons | Terminal & SSH (9.6.1), File editor (5.5.0), Samba share (10.0.0), Node-RED (14.0.2), SSH & Web Terminal (13.0.2), Mosquitto broker (6.1.3), Zigbee2MQTT (1.30.1-1), SQLite Web (3.7.0) |

Dashboards

| dashboards | 1 |

|---|---|

| resources | 1 |

| views | 1 |

| mode | storage |

Recorder

| oldest_recorder_run | 18 février 2023 à 14:44 |

|---|---|

| current_recorder_run | 18 février 2023 à 19:40 |

| estimated_db_size | 109.60 MiB |

| database_engine | sqlite |

| database_version | 3.38.5 |