Bonjour,

J’ai enfin terminé mes « migrations », ça m’a bien pris une semaine ses conneries :).

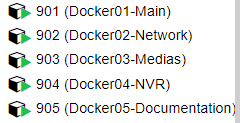

Les 5 CT LXC sont opérationnels:

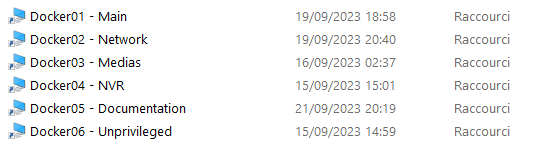

J’ai à présent bien séparé chacune de mes BDD (ce n’était pas le cas jusqu’à présent, j’avais par exemple kodi avec nextcloud…)

J’ai un CT Samba par docker, qui me permet d’accéder facilement aux répertoires à backuper de chaque CT:

J’y vois un peu plus clair dans mes dockers :).

Prochaine étape, automatiser le backupage de tout cela. Le mieux est biensur de gérer cela, de façon un minimum centralisée (en dehors de HA j’imagine). Des conseils la dessus? Des outils?

PS (voir HS ![]() ): Petit retour d’expérience suite à la migration (au cas ou ça aide/intéresse quelqu’un).

): Petit retour d’expérience suite à la migration (au cas ou ça aide/intéresse quelqu’un).

- Je me suis arraché les cheveux avec certains CTs, qui ne tournaient pas correctement en fonction de si j’était sur un CT LXC privileged ou pas, jusqu’a ce que je bascule sur une image de CT LXC « debian de base », au lieu d’une « turnkey ». J’ai beaucoup moins galérer avec l’image de base debian (il faut juste activer le ssh en plus au départ)

- Je me suis aussi arraché les cheveux avec les partages samba, notamment avec nextcloud qui utilise le user www-data. Ca a été beaucoup mieux après avoir fait les partages avec les UID 33 (pour ce CT).

- Petites frayeurs lors de la migration de unifi controller. Impossible d’avoir 2 instances de contrôleur en parallèle, donc on ne peux pas se dire j’installe la nouvelle instance avec tous les devices et je test avant la bascule. Les devices sont « affectés » a un contrôleur, du coup je me demande ce que ça doit être le jour ou un contrôleur lâche pour re gérer son réseau… (les backups seuls semble pas être suffisant du coup)

- Nextcloud m’a aussi donné du fil à re tordre. Pour des raisons que j’ignore l’application « Nextcloud Office » ne fonctionnai plus lorsque j’utilisai un nom de domaine, mais marchait avec l’ip, puis ne fonctionnai plus du tout, puis réinstallation, puis des milliers de tests de config, puis a un moment ça a refonctionné, je n’y touche plus mais je ne sais pas quel était le problème (peut être le vidate du /tmp dans docker).

- Pour NGINX proxy manager dans l’ensemble ça a bien été, juste j’ai du recréer tous mes paramètres à la main (ça va il n’y en a pas des kilomètres), car sous HA c’était stocké sous maria DB, la j’ai laissé de base avec sqlite (ce sera plus simple à backuper). J’aurais biensur pu repasser par une MariaDB.

- J’ai oublié de backuper mon LMS avant de supprimer l’ancienne install, j’ai donc du tout refaire de 0 (paramétrages…)

- J’ai découvert qu’avoir 2 instances de Frigate en même temps avec les mêmes paramètres de caméra posai problème avec MQTT (après réflexion ça semble logique, mais sur le coup j’ai passé quelques temps à me rendre compte du problème). D’ailleurs je constate que la consommation de CPU reste élevée malgré la Coral, je ferai un topic dédié à ce sujet.

Bonne journée, et merci pour votre aide!